This post is also available in Engels .

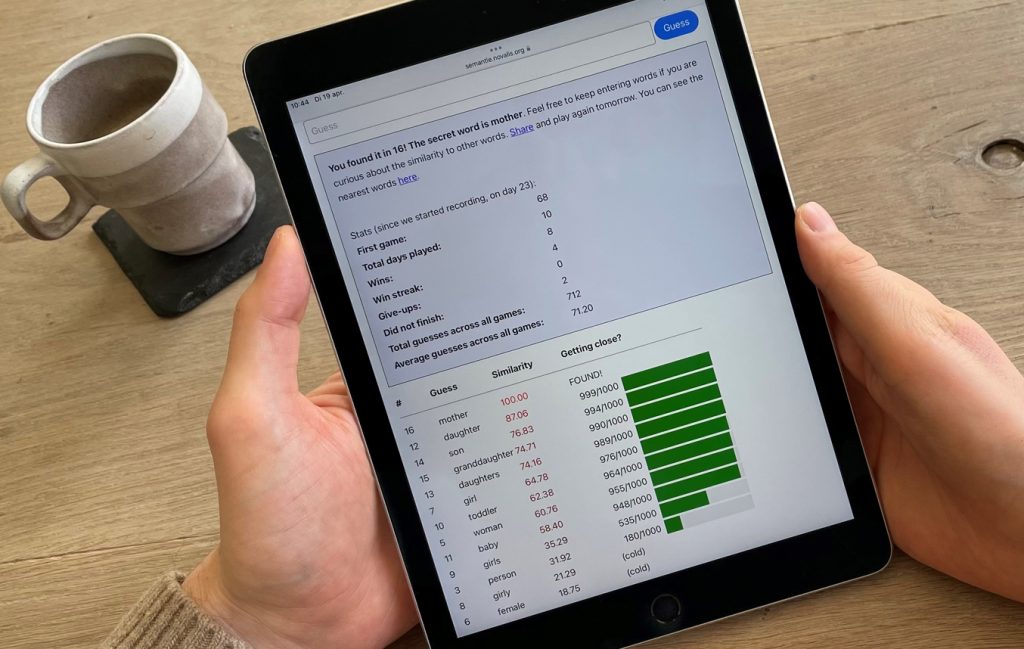

Sinds een paar weken ben ik helemaal in de ban van het spelletje Semantle. Het doel is dagelijks een geheim woord te raden op basis van de betekenis (ook wel semantiek genoemd). Bij elke gok geeft het spel aan in hoeverre jouw gok een vergelijkbare betekenis heeft als het antwoord, met behulp van een score tussen -100 (jouw gok is heel anders dan het antwoord) en 100 (jouw gok is het goede antwoord). Als ik nu bijvoorbeeld hond intyp, dan krijgt dat woord een gelijkenisscore van 2.20. Dit is vrij laag, dus hond lijkt niet erg op het antwoord. Maar hoe weet een computer eigenlijk hoe vergelijkbaar twee woorden zijn?

Hoe wordt de gelijkenis berekend?

Om te berekenen hoe vergelijkbaar twee woorden zijn, gebruikt het spel een algoritme genaamd Word2Vec. Het belangrijkste idee achter Word2Vec is dat je de betekenis van een woord kunt afleiden uit de woorden waarmee het woord vaak samen wordt gebruikt, net zoals je een inschatting zou kunnen maken van iemand op basis van zijn vrienden. Woorden met dezelfde “vrienden” hebben waarschijnlijk een vergelijkbare betekenis.

Het Word2Vec algoritme gebruikt een grote hoeveelheid teksten om de verbanden te vinden tussen woorden en hun vrienden. Op basis van de gevonden verbanden wordt elk woord “vertaald” naar een reeks getallen. Computers kunnen namelijk niet rekenen met woorden, maar wel met getallen. Vervolgens wordt de gelijkenis tussen twee woorden berekend als het verschil tussen de getallen: hoe dichter de getallen bij elkaar liggen, hoe vergelijkbaarder de woorden zijn.

Toepassingen naast het spelletje

Deze manier om woorden begrijpelijk te maken voor computers is natuurlijk niet uitgevonden voor dit spelletje, maar heeft allerlei nuttige toepassingen. Zo wordt het bijvoorbeeld gebruikt om vertaalmachines, zoals Google Translate, en spamfilters te verbeteren. Wat ook interessant is, is dat je op basis van deze berekende gelijkenissen ook taalfenomenen kunt voorspellen, bijvoorbeeld in hoeverre een woord zoals kat een ander woord zoals hond activeert in ons mentale lexicon (het woordenboek van ons brein). Het is een fascinerende vraag of deze manier waarop computers de betekenis van woorden leren en opslaan misschien wel lijkt op hoe ons brein dit doet!

Slimme Semantle tips

Ik raad jullie van harte aan om ook eens een potje Sematle te proberen (in het Nederlands of het Engels), of de speciale versie Pimantle waarbij de gelijkenis visueel gemaakt wordt in een soort sterrenstelsel. Op basis van het onderliggende algoritme kan ik jullie 3 tips meegeven:

- Het algoritme van Semantle heeft de woorden en hun verbanden geleerd door kranten te lezen, dus typische krantenwoorden als politiek of beleid zijn vaak een goeie gok.

- Het type woord speelt ook mee, bijvoorbeeld een zelfstandig naamwoord of een werkwoord, omdat werkwoorden vaak in vergelijkbare context voorkomen als andere werkwoorden (“Ik vind het leuk om te _”).

- Tegenovergestelde woorden (bijv. warm en koud) hebben voor het algoritme een vergelijkbare betekenis, want ze komen in vergelijkbare contexten voor (“De thee is te _”).

Het is een moeilijk spelletje, dus als je er ondanks mijn tips toch niet uitkomt, kun je altijd op het Reddit forum kijken voor hints 🙂

Credits

Auteur: Marlijn ter Bekke

Buddy: Felix Klaassen

Redactie: Wessel Hieselaar

Vertaling: Brittany van Beek

Redactie vertaling: Ellen Lommerse

Beeld van Marlijn ter Bekke