This post is also available in Engels .

Met de ontwikkeling van steeds meer “kunstmatige intelligentie” (AI staat voor Artificial Intelligence), raken we eraan gewend dat ons denken steeds meer ontlast wordt. Zo hebben we algoritmen die op internet zoeken naar voor ons relevante inhoud en ons gepersonaliseerde productaanbevelingen doen, en zijn er al grenscontroles vervangen door geautomatiseerde gezichtsherkenning. Hoe meer we uitbesteden aan algoritmen, hoe minder we zelf hoeven te nadenken, waarnemen en handelen. De algoritmen doen dat voor ons.

Hetzelfde geldt in toenemende mate voor de wetenschap. Vroeger werd er gebruik gemaakt van zakrekenmachines of SPSS (een statistisch computerprogramma voor de sociale wetenschappen), maar tegenwoordig gebruiken wetenschappers routinematig geavanceerde, zogenaamde machine learning (ML) algoritmen om gegevens te analyseren, ordenen en interpreteren. Ingewikkelde berekeningen die je onmogelijk zelf kunt bedenken kunnen in luttele seconden door computers worden uitgevoerd. Het is gemakkelijker geworden om een ML-algoritme in te zetten dan om te bedenken of je het algoritme überhaupt zou moeten gebruiken.

Een bevooroordeeld algoritme

Een pijnlijk voorbeeld hiervan betreft een wetenschappelijk artikel dat recent werd gepubliceerd in Nature Communications. De auteurs creëerden onbewust een algoritme dat verontwaardiging veroorzaakte op sociale media. De auteurs leken verrast. Hoe konden mensen hier zo verbolgen door zijn? De onderzoekers hadden tenslotte slechts een algoritme getraind om “betrouwbaarheid” in gezichten te herkennen, net zoals mensen dat kunnen, dachten de onderzoekers. De onderzoekers hadden zich echter niet gerealiseerd dat ze (onbedoeld) de pseudowetenschap “fysionomie” nieuw leven inbliezen.

Fysionomie is het achterhaalde idee dat persoonlijke kenmerken (bijv. betrouwbaarheid) van iemands gezicht kunnen worden ‘afgelezen’. Fysionomie heeft in het verleden bijgedragen aan “wetenschappelijk” racisme en antisemitisme, met rampzalige gevolgen. Geen enkele wetenschapper wil per ongeluk een moderne variant van fysionomie creëren. Toch is dat juist wat hier gebeurde. Hoe was dit mogelijk?

Het ging mis bij het omzetten van kennis uit de psychologie naar kunstmatige intelligentie. Psychologisch onderzoek heeft aangetoond dat mensen “betrouwbaarheids”-indrukken vormen die afhangen van gelaatstrekken, waarvan sommigen door de persoon zelf beheerst worden (bijv. glimlachen) maar ook veel niet (bijv. afstand tussen de ogen, breedte van de neus, ruststand van de mond, enz.). Met het doel gezichtsuitdrukkingen in portretten te analyseren, redeneerden de auteurs van het wetenschappelijk artikel in Nature Communications dat als we een algoritme maken dat menselijke “betrouwbaarheids”indrukken nabootst, zo’n algoritme ook kan detecteren hoe “betrouwbaar” iemand wil lijken. Het algoritme vormt echter, net als mensen, stereotypische vertoningen op basis van kenmerken waarover de persoon geen controle heeft. Het is fysionomie in een nieuw geautomatiseerd jasje.

Showcases van dit algoritme zijn al in de populaire media verschenen, waaronder “betrouwbaarheids”-scans van foto’s van beroemdheden. Men hoopt dat onderzoekers de gevolgen hiervan tegengaan. Dit algoritme zou anders een gevaarlijke aanvulling kunnen worden op de al groeiende lijst van discriminerende algoritmen die worden gebruikt bij bijvoorbeeld bewaking, grenscontrole en sollicitatieprocedures. De redactie van Nature Communications is een onderzoek gestart en de academische gemeenschap wacht op hun formele verklaring.

Onthulling van ondoordacht denken

De case study laat een verscheidenheid aan verkeerde oordeelvorming zien, waaronder onvoldoende historisch besef en onethische verspreiding. Maar laten we ons hier concentreren op één duidelijk kenmerk van onzorgvuldig denken: in essentie begaat het onderzoek een van de meest fundamentele fouten in de logica.

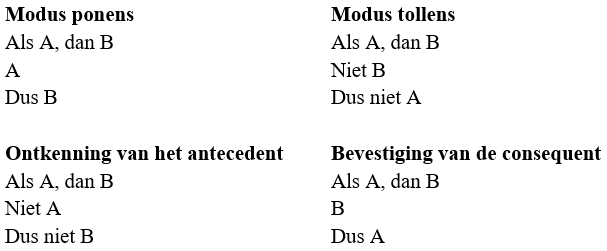

Logica is de studie van het goed redeneren. In elke inleidende les over logica leert men de twee geldige argumentatieschema’s: modus ponens en modus tollens, en twee formele denkfouten: ontkenning van het antecedent en bevestiging van de consequent. De redenering in de Nature Communications-studie was een voorbeeld van de laatstgenoemde denkfout: “als een persoon betrouwbaar wil lijken, zullen ze meer ‘betrouwbaarheid’ in hun gezicht tonen (bijvoorbeeld door te glimlachen). Daarom, als een persoon meer ‘betrouwbaarheid’ in hun gezicht vertoont (bijvoorbeeld als zo’n persoon een mond heeft die in een neutrale positie eruitziet als een “glimlach”) wil de persoon betrouwbaarder overkomen.” Dat deze redenering niet klopt moet duidelijk zijn voor iedereen die hierover nadenkt en vooral voor elke onderzoeker die kunstmatige intelligentie gebruikt.

Met mooie algoritmen tot je beschikking loop je mogelijk een groter risico niet goed na te denken. Tegelijkertijd kunnen ondoordachte algoritmen meer schade aanrichten, efficiënter en op grotere maatschappelijke schaal. Denk hier goed over na. Laat kunstmatige intelligentie niet voor je denken.

Iris van Rooij

Bijzonder Lorentz Fellow van NIAS-KNAW

Computational Cognitive Science, Donders Centre for Cognition

Opmerking van de auteur:

Deze Donders Wonders blog is een aanpassing en uitbreiding van de brief ‘Pas op met mengen psychologie in kunstmatige intelligentie’ van Iris van Rooij, gepubliceerd in het NRC 5-10-2020.

Aanvullende literatuur

– O’Neil, C. (2016). Weapons of Math Destruction: How Big Data Increases Inequality and Threatens Democracy. Penguin Books Ltd.

– Agüera y Arcas, B., Mitchell, M., and Todorov, A. (2017). Physiognomy’s New Clothes https://medium.com/@blaisea/physiognomys-new-clothes-f2d4b59fdd6a

Opmerking:

Op het moment van schrijven van deze blog is het volgende in circulatie: “Open brief van wetenschappers aan de Nederlandse overheid over autonome wapens”

Credit

Originele taal: Engels

Buddy: Felix Klaassen

Editor: Marisha Manahova

Vertaling: Ellen Lommerse

Editor vertaling: Wessel Hieselaar

Uitgelichte afbeelding verkregen van Pixabay via Pexels