This post is also available in Engels .

Veel onderzoekers stellen dat grote taalmodellen (LLM’s – large language models), zoals chatbot ChatGPT, niet echt intelligent zijn omdat ze geen belichaming hebben. Met andere woorden: ze hebben geen lichaam waarmee ze kunnen waarnemen of handelen in de wereld. In de cognitieve wetenschap betekent belichaming dat intelligentie voortkomt uit een brein dat in wisselwerking staat met zijn omgeving – via een lichaam dat waarneemt, handelt en opnieuw waarneemt, in een voortdurende cyclus die bekendstaat als de sensorisch-motorische lus. Zonder deze lus, zeggen critici, bootsen systemen met kunstmatige intelligentie (KI) weliswaar de taal na, maar begrijpen ze die niet echt.

Aan deze kritiek ligt vaak een veronderstelling ten grondslag: dat waarnemen en handelen op hetzelfde ritme in de tijd moeten plaatsvinden, bijna in een directe 1-op-1 wisselwerking. Maar wat als we die aanname eens loslaten?

Verlate belichaming: niet nooit, alleen later – via ons mensen

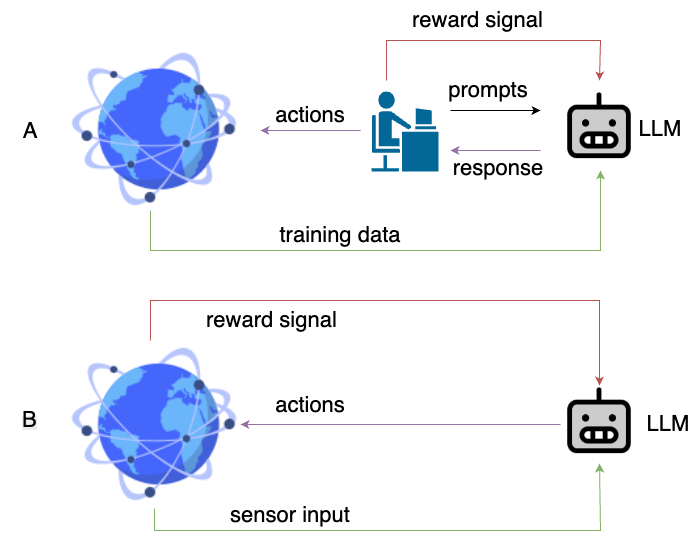

In de praktijk handelen chatbots wél in de wereld, alleen niet direct en niet op het tijdschema dat we gewend zijn. Wanneer we een LLM een prompt geven, genereert het model een reactie. Die reactie beïnvloedt ons: misschien volgen we een suggestie op, ondernemen we actie op basis van een idee, of nemen we een beslissing. Die actie verandert op zijn beurt de wereld, op welke schaal dan ook. Uiteindelijk komt die verandering weer terug in de vorm van nieuwe data, waarmee de volgende generatie van het taalmodel wordt getraind. De cyclus is traag, niet simpelweg 1-op-1, maar ze is er wél echt.

Deze mens-AI-lus is een vorm van indirecte belichaming – waarbij wij, de gebruikers, fungeren als de zintuigen en ledematen van het systeem. De chatbot heeft geen eigen lichaam, maar beweegt via het onze – alleen op een ander ritme.

Mensen geven ook terugkoppeling aan LLM’s: we liken, negeren of bekritiseren bepaalde antwoorden. Deze volledige kringloop lijkt sterk op de reinforcement learning-cyclus – oftewel leren door beloning en straf – die in de kern gebaseerd is op belichaming.

A. De vertraagde belichaming cyclus die van chatbots wordt gemaakt.

B. Sensor-actie-cylus gebruikt bij reinforcement learning.

Diagram gemaakt met behulp van draw.io

De muur van de Chinese kamer verschuift.

Het gedachte-experiment van John Searle – de Chinese Kamer – beschrijft een persoon die geen Chinees kent, maar in een afgesloten kamer zit met een regelboek waarmee hij Chinese symbolen volgens vaste regels uitleest en zelf produceert. Voor een buitenstaander lijkt het alsof de persoon Chinees begrijpt, maar volgens Searle is er alleen sprake van symboolmanipulatie, niet van echt begrip. We plaatsen KI vaak in die kamer, en onszelf erbuiten, om dan te concluderen dat machines geen echte intelligentie bezitten.

Maar waar bevindt die muur zich dan eigenlijk in een wereld met grote taalmodellen? Zit de chatbot nog steeds “binnen”, en wij “buiten”? Of bevinden we ons juist samen in de kamer en zijn we medeverantwoordelijk voor de betekenis die ontstaat? Als mensen de prompts aanleveren, reageren op de output, en zo nieuwe trainingsdata genereren, zijn we dan niet onderdeel van het systeem geworden? En dus ook binnen de kamer?

Deze gedachte sluit aan bij de bekende theorie van Clark en Chalmers uit 1998 over de Extended Mind: wanneer hulpmiddelen, zoals een notitieboekje of een rekenmachine, zo nauw verbonden raken met ons denken, worden ze onderdeel van ons eigen cognitief systeem. Waarom zouden we chatbots dan uitsluiten?

Een ander perspectief.

Misschien is het voor het eerst dat een hulpmiddel niet alleen ingebed is in onze wereld, maar ook complex genoeg is om kenmerken van natuurlijke intelligentie te vertonen. Critici zullen wellicht blijven zeggen dat de gelijkenis oppervlakkig is, omdat de bouwstenen en architectuur van grote taalmodellen niet lijken op welke bekende hersenregio dan ook. Maar de bijzondere octopus, wier hersenen zich meer dan 500 miljoen jaar geleden van die van ons heeft afgesplitst, herinnert ons eraan dat intelligentie geen structurele gelijkenis vereist. Wat het wel nodig heeft, is functioneren binnen een cirkel van interactie, aanpassing en betekenisvolle gevolgen en voldoende complexiteit.

En wellicht is dat juist het punt: de rol die een hersenonderdeel of een deel van een intelligent systeem speelt binnen een oorzakelijke lus bepaalt hoe het zich ontwikkelt, of het nu kunstmatig is of niet. Systemen die vergelijkbare problemen oplossen, kunnen qua vorm naar elkaar toe groeien. Daar zien we zelfs al tekenen van! Zo tonen fMRI onderzoeken aan dat de verborgen lagen van LLM’s overeenkomen met hersenactiviteit bij mensen tijdens taalverwerking. Deze modellen zijn niet gebouwd om ons na te bootsen, maar hun interne representaties weerspiegelen hoe wij verhalen en betekenis verwerken. Misschien is de vraag daarom niet of chatbots intelligent zijn, maar of wij samen met hen intelligenter zijn geworden.

Auteur: Siddharth Chaturvedi

Buddy: Amir Homayun Hallajian

Redactie: Xuanwei Li

Vertaling: Natalie Nielsen

Redactie vertaling: Lucas Geelen